Tekst Christel van der Meer

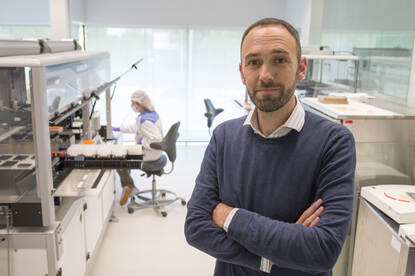

Stel je voor: iemand eist in een video losgeld na het kidnappen van een jong meisje. In die video is de kidnapper gedeepfaket: hij heeft het hoofd van een ander persoon. Als de politie niet weet dat het hierbij om een deepfake gaat, zouden ze kunnen zoeken naar de verkeerde persoon. Iemand die er mogelijk niets mee te maken heeft. Het is mede daarom ook volgens het Openbaar Ministerie van belang dat we deepfakes op een forensisch verantwoorde wijze weten te onderzoeken. UvA-studente Meike Kombrink doet onder begeleiding van Zeno Geradts (forensisch onderzoeker bij het NFI en bijzonder hoogleraar aan de UvA) onderzoek naar hoe computermodellen deepfakes kunnen detecteren.

Waar we lang dachten dat iets ‘echt’ was omdat het op beeld stond, kunnen we dat met de komst van deepfakes niet altijd meer met zekerheid zeggen. Hoewel de gedeepfakete kidnapvideo nu nog een fictief voorbeeld is, volgt het OM de ontwikkelingen voor wat betreft deepfakes met grote belangstelling. “In het strafrecht zijn we ze nog niet tegengekomen. We denken dat als ze er wel waren geweest er zeker door de verdediging naar gevraagd zou zijn voor nader onderzoek. Dit gebeurde bijvoorbeeld in het verleden ook rondom de opnames van tapgesprekken”, aldus het OM.

Volgens forensisch onderzoeker Geradts gebruiken criminelen steeds vaker deepfakes. “We weten bijvoorbeeld dat volwassenen met deepfake onherkenbaar worden gemaakt in kinderpornovideo’s”, zegt hij. “Als een verdachte tijdens een rechtszaak stelt dat die kinderpornovideo inderdaad deepfake is en hij dus niet écht in die video zat, dan moet dat wel te bewijzen zijn. We moeten kunnen aantonen of er sporen zijn die wijzen op een gemanipuleerde video, of juist niet.” Daarom is volgens Geradts veel onderzoek nodig naar het detecteren van deepfakes. Ook omdat de makers van deepfakes ruimschoots in de meerderheid zijn: 90 procent van de investeringen gaat naar het verbeteren van de techniek van deepfakes, slechts 10 procent naar het detecteren van dit soort video’s.

Wat is een deepfake

Deepfakes zijn video’s waarbij een gezicht is vervangen of alleen de mond wordt vervangen. Zo kan je bekende mensen, zoals Mark Rutte of Donald Trump, dingen laten zeggen die ze zelf niet daadwerkelijk hebben gezegd. Om een deepfake te maken, hebben computermodellen veel data, video’s, nodig om bijvoorbeeld het hoofd van Rutte of Trump na te maken.

De computermodellen leren zichzelf door middel van Deep Learning het hoofd van zo’n persoon na te maken. Van bekende personen bestaan vaak veel video’s waardoor er dus voldoende input is om deze computermodellen te trainen. “Bovendien moet het model veel berekeningen doen. Tegenwoordig kan dit in zeer korte tijd, daarom is het nu zo makkelijk en populair om een deepfake te maken”, legt Geradts uit.

Maar het idee achter deepfakes, een ander gezicht iets laten doen of zeggen, bestaat al veel langer. “Ook in de jaren negentig gebruikten filmstudio’s al technieken om beelden te manipuleren”, vertelt Geradts. Denk aan de video Black or White van Michael Jackson waarbij het hoofd steeds verandert: van man naar vrouw, van jong naar oud.

Een paar jaar geleden was het nog goed mogelijk om deepfakes met het blote oog te herkennen. Je zag afwijkende lijnen van het gezicht, een flikkering van het licht op iemands gezicht of een heel blokkerig stukje beeld bij bijvoorbeeld de kin. “Maar zo makkelijk herken je dat nu niet meer. Zeker als het echt professioneel gedaan is”, zegt Geradts. Daarom zijn er nu al jaren computermodellen die deepfakes proberen te herkennen. Ze proberen onderliggende patronen te herkennen die wijzen op een deepfake. “Zo is er momenteel een onderzoek van een student die een computermodel traint op lipsynchronisatie. Dus maken de lippen de juiste beweging bij de uitgesproken tekst?”, legt hij uit.

Video’s met compressie

Meike Kombrink onderzoekt voor haar afstudeerstage in hoeverre computermodellen deepfakes kunnen herkennen waar compressie op zit. “Video’s op internet en sociale media worden altijd kleiner gemaakt, dan zit er compressie op. Dit is noodzakelijk omdat ze anders te veel data gebruiken. Gebeurt dat niet dan zouden de Facebooks van deze wereld nog meer datacenters nodig hebben”, legt de UvA-student uit. Vrijwel alle onlinevideo’s hebben daarom te maken met een bepaalde mate van compressie.

De algoritmes waar Kombrink mee werkt, zijn eerder getraind op ‘pure’ video’s. “Dit zijn hele heldere, mooie video’s zónder compressie. Met mijn onderzoek wil ik erachter komen of een bestaand algoritme ook op video’s mét compressie werkt. Door het verkleinen van zo’n video is het mogelijk dat bepaalde informatie verloren gaat. Informatie die het algoritme nodig heeft om te herkennen of het een deepfake is. Ik onderzoek in hoeverre een bestaand algoritme nog kan zien of iets een deepfake is als een video gecomprimeerd is”, legt ze uit. De resultaten van haar onderzoek worden later dit jaar verwacht.

“Wat als we deepfakes niet kunnen herkennen? We detecteren nu 80, maximaal 90 procent van de deepfakes"

Onderzoek deepfakes noodzakelijk

Deepfakes zullen waarschijnlijk niet snel verdwijnen. De reden dat meer onderzoek noodzakelijk is. “Europa heeft dit ook hoog op de agenda staan”, vertelt Geradts. Er wordt gewerkt aan regels die misbruik van deepfakes tegen moeten gaan. Maar ook met regels en wetgeving zal het herkennen van deepfakes belangrijk blijven om bijvoorbeeld in de opsporing niet achter de verkeerde mensen aan te gaan. “Stel dat je een bewakingscamera hackt en er een realtime deepfake van kan maken waarbij je dus het hoofd of lichaam van iemand anders ziet tijdens een inbraak. Dan heb je dus onjuiste bewakingsbeelden waarbij je niet weet dat je naar de verkeerde persoon op zoek bent”, schetst Geradts. Hij benadrukt dat dat nu nog niet aan de orde is, maar dat we wel op allerlei scenario’s voorbereid zijn.

Het maken en herkennen van deepfakes zal altijd een kat-en-muisspel zijn. “De makers zullen in eerste instantie altijd voorlopen”, verwacht Geradts. En daar schuilt ook wel een deel van het gevaar. “Wat als we deepfakes niet kunnen herkennen? We detecteren nu 80, maximaal 90 procent van de deepfakes. Dat klinkt hoog, maar we missen dan dus ook één of twee op de tien deepfakes. Het liefst wil je dat we naar een detectiepercentage van 99,5 procent gaan”, zegt hij. “De makers zullen ons vaak een stap voor zijn”, verwacht ook Kombrink. “Maar uiteindelijk zullen we ook die video’s gaan herkennen. We zullen soms even achter lopen, maar uiteindelijk komen we altijd bij”, besluit ze optimistisch.